Nếu lĩnh vực học máy (machine learning) có một điểm yếu nguy hiểm tương đương với kịch bản tấn công 51% trong các hệ thống tiền mã hóa (blockchain), thì khả năng dễ bị phá hoại từ kiểu tấn công đối kháng (adversarial attack) chính là điểm yếu sống còn của các hệ thống học máy. Các hệ thống trí tuệ nhân tạo khác nhau trên nhiều lĩnh vực như xử lý và nhận diện đối tượng trong lĩnh vực xử lý ảnh, đến các kỹ thuật xử lý ngôn ngữ tự nhiên (NLP), cụ thể hệ thống nhận diện tiếng nói tự động (Automatic Speech Recognition Systems), Speech-To-Text, hay các hệ thống nhận diện và phòng chống tấn công mạng, mã độc trong lĩnh vực an ninh mạng và an toàn máy tính đều có thể bị tổn thương, thậm chí bị vô hiệu hóa trước kiểu tấn công này.

Vào năm 2014, việc công bố một nghiên cứu từ nhóm nghiên cứu trí tuệ nhân tạo (AI) do Google đứng đầu đã mở ra một lĩnh vực tấn công (hacking) mới, được gọi là kiểu tấn công đối kháng (adversarial attack). Bằng các kỹ thuật thực hiện kiểu tấn công này, bài báo của Christian Szegedy không chỉ làm thay đổi sự hiểu biết của chúng ta về cách thức hoạt động của máy học (machine learning) mà còn cho thấy các vấn đề thực tế ảnh hưởng đến việc ứng dụng hứa hẹn nhất về mặt thương mại của cuộc cách mạng AI có thể bị phá hoại.

Cụ thể, bằng cách thay đổi một cách tinh tế các hình ảnh thử nghiệm khác nhau từ cơ sở dữ liệu ImageNet, các nhà nghiên cứu của Google đã khiến một hệ thống máy học phân loại nhầm các tấm ảnh này là hình ảnh của “đà điểu” mặc dù hệ thống này được xây dựng trên mạng nơ-ron tích chập AlexNet – một mạng CNN rất phổ biến và được đánh giá cao trong lĩnh vực phân loại ảnh.

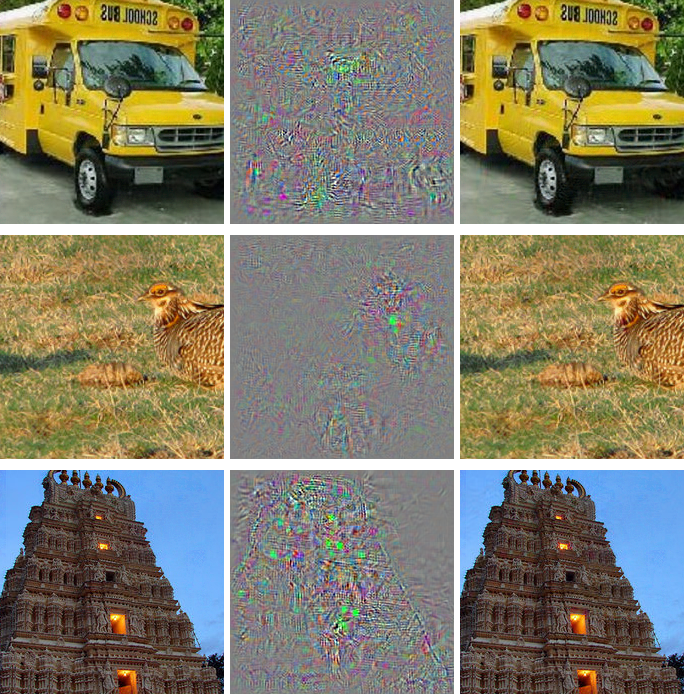

Hình 1. Tấn công đối kháng nhắm vào các hệ thống phân loại ảnh, thực hiện bởi Christian Szegedy, 2014

Theo như Hình 1, cột bên trái là các hình ảnh gốc được lấy từ tập dữ liệu ImageNet, trong khi cột giữa là thông tin ma trận mà các nhà nghiên cứu thêm vào ảnh. Cột bên phải là các bức ảnh sau khi thêm vào các thông tin ma trận khác biệt, những hình ảnh này sau đó được hệ thống máy học phân loại thành các bức ảnh của “đà điểu”.

Cuộc tấn công đối kháng nhắm vào các hệ thống trí tuệ nhân tạo là sự lạm dụng một tính năng cơ bản trong mô hình khái niệm của các hệ thống máy học dựa trên hình ảnh. Nó lợi dụng khai thác quá trình loại bỏ mà hệ thống sử dụng khi ước tính nhãn nào sẽ áp dụng cho hình ảnh. Tấn công đối kháng trong trí tuệ nhân tạo là một lỗ hổng tự thân nằm bên trong cấu trúc cơ bản của các mạng lưới thần kinh nhân tạo (deep neural network). Cho đến nay, những nhà nghiên cứu AI giỏi nhất cũng đang gặp khó khăn trong việc đưa ra các biện pháp phòng vệ hiệu quả chống lại ảnh hưởng của loại tấn công đối kháng này.

Đây không phải là lỗi lập trình có thể sửa chữa theo kiểu sự cố Y2K, mà là một lỗ hổng kiến trúc có hệ thống, là rào cản cho các bước đột phá mới trong lĩnh vực AI. Các mối đe dọa sẽ tiếp tục tồn tại và thích nghi dần dần từ giai đoạn phát triển nghiên cứu học thuật và lý thuyết hiện tại đến các hệ thống AI phục vụ kinh doanh thương mại, quân sự và dân sự trong tương lai.

Kỳ tới: Tấn công đối kháng trong các hệ thống xử lý tiếng nói, ngôn ngữ tự nhiên.

Tham khảo: HackerNoon